你是否在寻找一款功能强大、支持多种AI模型的桌面客户端?Cherry Studio 是一款集多模型对话、知识库管理、AI绘画、翻译等功能于一体的全能AI助手平台。它不仅支持多种主流AI服务,还能帮助用户构建个性化的知识库,提升工作效率。

Cherry Studio 是一款专注于本地化部署与交互的开源大语言模型(LLM)客户端,支持在个人电脑上离线运行主流AI模型(如 Meta Llama 3、阿里云 Qwen、智谱 ChatGLM、百川 Baichuan 等),为开发者、研究人员及AI爱好者提供安全、私密且可定制的本地AI推理环境。

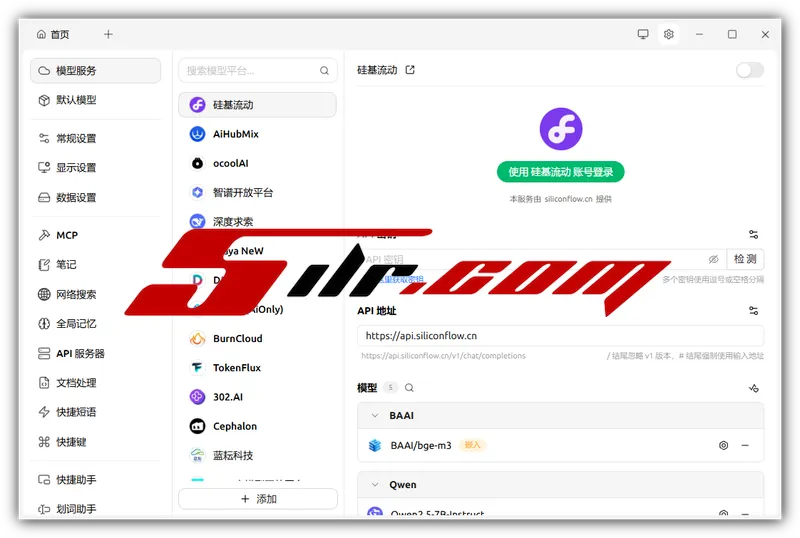

随着大模型应用的普及,用户对数据隐私、响应延迟和网络依赖问题日益关注。Cherry Studio 通过轻量级桌面客户端,简化了本地模型部署流程,用户无需掌握复杂的命令行操作或深度学习框架,即可一键下载、加载并运行GGUF、Safetensors等格式的量化模型。软件内置模型管理器,支持多模型切换、上下文长度调节、GPU加速(CUDA、Metal、Vulkan)与系统资源监控,确保在消费级显卡(如NVIDIA RTX系列)或苹果M芯片设备上流畅运行。

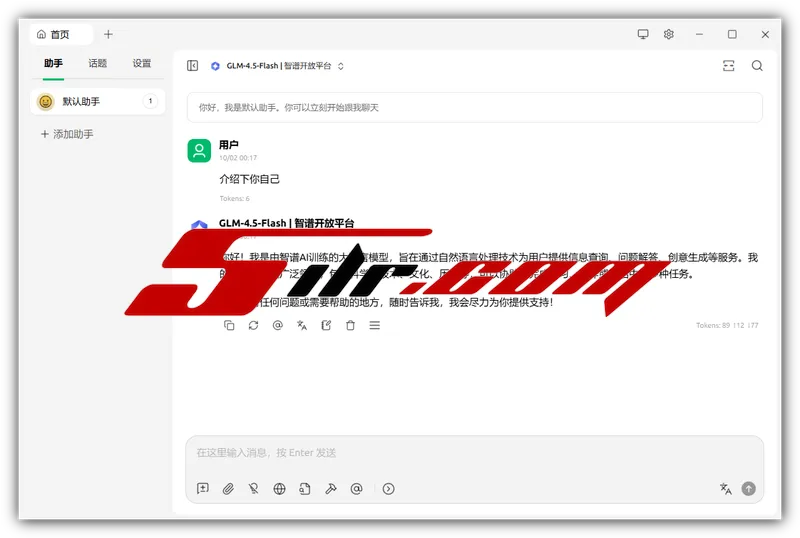

该工具提供类聊天界面,支持多轮对话、提示词模板(Prompt Templates)、角色扮演设定与会话导出,便于进行AI测试、知识问答或内容创作。同时开放API接口,可与外部应用集成,构建本地化AI工作流。所有数据处理均在本地完成,不上传任何用户输入至云端,彻底保障敏感信息与商业机密的安全。

Cherry Studio 还支持插件扩展机制,用户可安装第三方工具增强功能,如联网搜索、代码执行、语音合成等,实现高度个性化的AI体验。其简洁直观的界面降低了本地AI使用门槛,是探索大模型技术、构建私有知识库或开发AI应用的理想入口。

小编总结:Cherry Studio 以易用性、隐私保护与模型兼容性为核心优势,成功将复杂的本地AI部署过程平民化。对于追求数据自主权与定制化AI能力的用户而言,是一款不可或缺的本地大模型交互平台。

截图预览

功能特色

- 支持本地离线运行Llama 3、Qwen、ChatGLM等主流开源模型;

- 提供图形化界面,简化模型下载、加载与参数配置流程;

- 兼容GGUF、Safetensors等量化格式,降低硬件要求;

- 支持GPU加速推理,提升本地响应速度;

- 内置会话管理、提示词模板与角色设定功能;

- 开放本地API与插件系统,便于功能扩展与集成;

更新内容

cherrystudiocn.com

下载地址

夸克云:https://pan.quark.cn/s/8e560d6dec8d

迅雷云:https://pan.xunlei.com/s/VOaVa-QYPm2zfxOiCSjjW40vA1?pwd=xb9z#

百度盘:https://pan.baidu.com/s/18UnB-mh157Ce9GzATFuPgw?pwd=gx3c

123盘:https://www.123912.com/s/di8wvd-qGvSd